En busca de fisuras en el modelo cosmológico estándar

Nuevas simulaciones por ordenador siguen la formación de galaxias y su estructura cósmica circundante con una precisión estadística sin precedentes

Donostia / San Sebastián (País Vasco). 18 de julio de 2023. Un equipo internacional de astrofísicos, del que forman parte investigadores del Donostia International Physics Center (DIPC), ha presentado un proyecto que simula la formación de galaxias y estructuras cósmicas de gran escala a lo largo de franjas asombrosamente grandes del espacio. Los primeros resultados de su proyecto MillenniumTNG (MTNG) acaban de publicarse en una serie de 10 artículos de la revista Monthly Notices of the Royal Astronomical Society (MNRAS). Los nuevos cálculos ayudarán a someter el modelo cosmológico estándar a pruebas de precisión que podrían dilucidar aspectos fundamentales del universo.

En las últimas décadas, los cosmólogos se han acostumbrado a una desconcertante conjetura: la materia del universo está dominada por una extraña “materia oscura” y su expansión acelerada la provoca una “energía oscura” aún más extraña que actúa como alguna forma de antigravedad. La materia visible ordinaria, que es la materia que forma los planetas, las estrellas y las galaxias, como nuestra Vía Láctea, representa menos del 5 % de la mezcla cósmica. Este modelo cosmológico aparentemente extraño se conoce como ΛCDM.

ΛCDM puede explicar un gran número de observaciones cosmológicas, que van desde la radiación cósmica de microondas (el calor remanente dejado por el Big Bang) hasta la disposición de las galaxias en forma de “red cósmica” a lo largo de una compleja red de filamentos. Sin embargo, la naturaleza física de los dos principales ingredientes de ΛCDM, materia oscura y energía oscura, resulta aún hoy incomprensible. Este misterio ha llevado a los astrofísicos a buscar lagunas en la teoría del ΛCDM que hagan fracasar sus predicciones. Sin embargo, la búsqueda de «fisuras» requiere nuevos datos de observación extremadamente sensibles, así como predicciones precisas sobre lo que realmente implica el modelo ΛCDM.

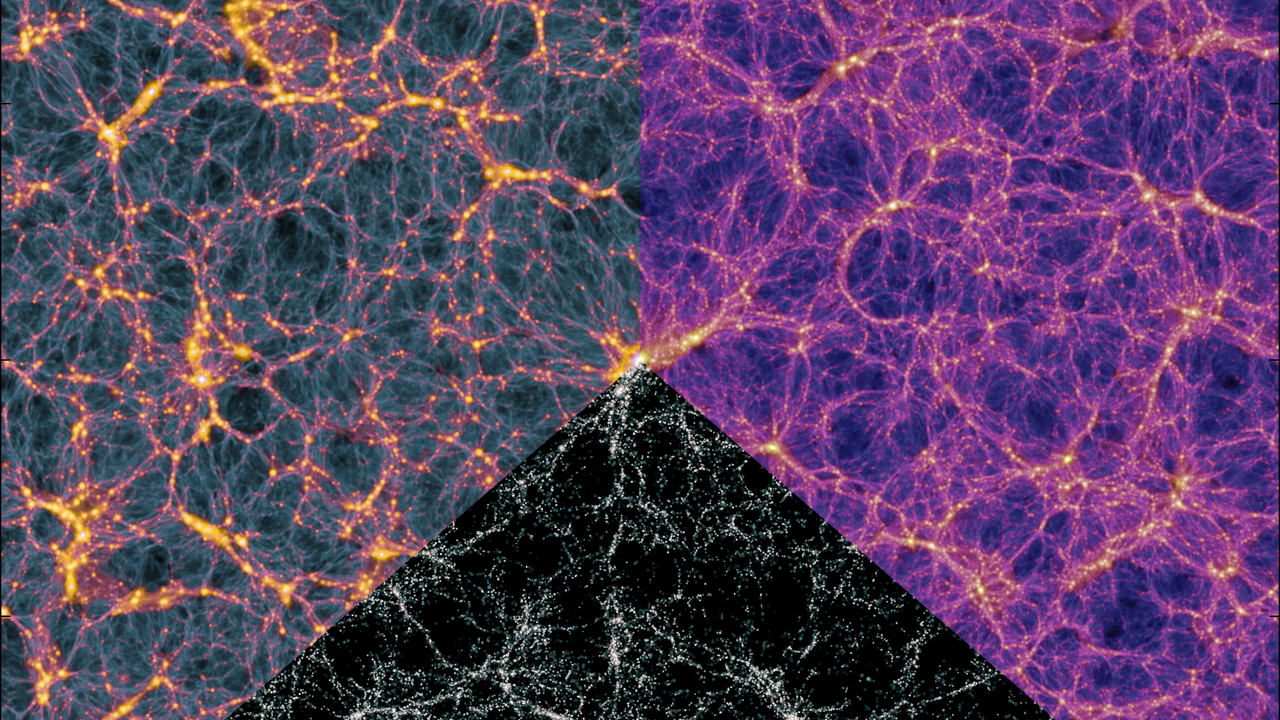

Esta semana, un equipo internacional de investigadores del DIPC, junto con el Instituto de Astrofísica Max Planck (MPA), la Universidad de Harvard, la Universidad de Durham y la Universidad de York, han dado un paso decisivo en el reto de comprender el modelo ΛCDM. Han desarrollado el conjunto más completo de simulaciones cosmológicas hasta la fecha. Para este proyecto usaron software especializado en dos superordenadores extremadamente potentes (Cosma8 en el Reino Unido y SuperMUG en Alemania), donde 300.000 núcleos de computadora rastrearon la formación de alrededor de cien millones de galaxias en una región del universo de alrededor de 2300 millones de años luz (ver Figura 1).

MillenniumTNG simula los procesos de formación de galaxias directamente sobre volúmenes tan grandes que pueden considerarse representativos del universo en su conjunto. Estas simulaciones permiten evaluar de manera precisa el impacto de procesos astrofísicos tales como las explosiones de supernovas y los agujeros negros supermasivos en la distribución de la materia cósmica. Además, estos cálculos simulan directamente la presencia de neutrinos masivos. Se trata de partículas fundamentales extremadamente ligeras que representan como máximo el 2 % de la masa en el universo. A pesar de ser muy pequeños, los datos de los estudios cosmológicos, como los del satélite Euclid de la Agencia Espacial Europea, recientemente lanzado, pronto alcanzarán un grado de precisión tal que podrían permitir detectar por primera vez neutrinos en el cosmos.

Los primeros resultados del proyecto MillenniumTNG arrojan abundantes predicciones teóricas que refuerzan la importancia de las simulaciones por ordenador en la cosmología moderna. El equipo ha escrito y presentado diez artículos científicos introductorios para el proyecto que acaban de aparecer simultáneamente en la revista MNRAS.

Uno de los estudios, dirigido por el DIPC, se centró en crear herramientas que rápidamente generen millones de universos virtuales con diferentes suposiciones sobre el modelo cosmológico. «El proyecto nos ha permitido desarrollar nuevas formas de entender la relación entre materia oscura y galaxias, y cómo podemos usarlas para encontrar fisuras en el modelo ΛCDM», dice el Dr. Sergio Contreras, primer autor de este estudio del equipo MTNG, quien analizó los datos usando superordenadores en el Centro de Supercomputación del DIPC. Gracias a los algoritmos de aprendizaje automático, el equipo fue capaz de predecir cómo se vería el universo si los neutrinos tuvieran diferentes masas o si la ley de gravedad fuera diferente a la que propuso Einstein. «En los últimos años hemos visto una revolución en la forma de construir modelos computacionales, y es emocionante ver cuántas puertas nuevas se han abierto para entender aspectos fundamentales del cosmos», dice el profesor Raúl Angulo, investigador del DIPC.

Otros estudios del proyecto MTNG incluyen cómo la forma de las galaxias está condicionada por la distribución de la materia a gran escala; predicciones sobre la existencia de una población de galaxias muy masivas en el universo primitivo recientemente descubierta con el telescopio espacial James Webb; y la construcción de universos virtuales que contienen más de mil millones de galaxias.

El aluvión de resultados iniciales de las simulaciones de MillenniumTNG deja claro que serán de gran ayuda para diseñar mejores estrategias para el análisis de los próximos datos cosmológicos. El investigador principal del equipo, el director del MPA Prof. Volker Springel, afirma que «MillenniumTNG combina avances recientes en simulaciones de formación de galaxias con el campo de estructura cósmica a gran escala, lo que permite mejorar el modelado teórico de la conexión de las galaxias con la columna vertebral de la materia oscura del universo. Esto puede ser muy útil para poder avanzar en cuestiones clave de cosmología, como, por ejemplo, cuál es la mejor manera de limitar la masa de los neutrinos con datos de estructuras de gran escala». La principal simulación hidrodinámica requirió aproximadamente 170 millones de horas de CPU, lo que equivale a hacer funcionar un ordenador QuadCore durante casi 5000 años. Además, la totalidad del proyecto produjo más de 2 petabytes de datos de simulación, lo cual supone abundante material para seguir investigando. Esto mantendrá a los científicos participantes ocupados durante muchos años.